Le TPU de Google n’est pas un gadget de plus dans la pile IA. C’est une brique stratégique pour entraîner et inférer plus vite, plus propre et moins cher, surtout quand les deadlines serrent et que les GPU se font rares. Si tu dois accélérer un modèle, réduire ta facture cloud ou stabiliser tes latences en prod, comprends cette techno, puis exploite-la au maximum.

Habitué au story des 15 secondes ? Voilà ce que tu dois retenir :

| ✅ Point clé | 🎯 Détail |

|---|---|

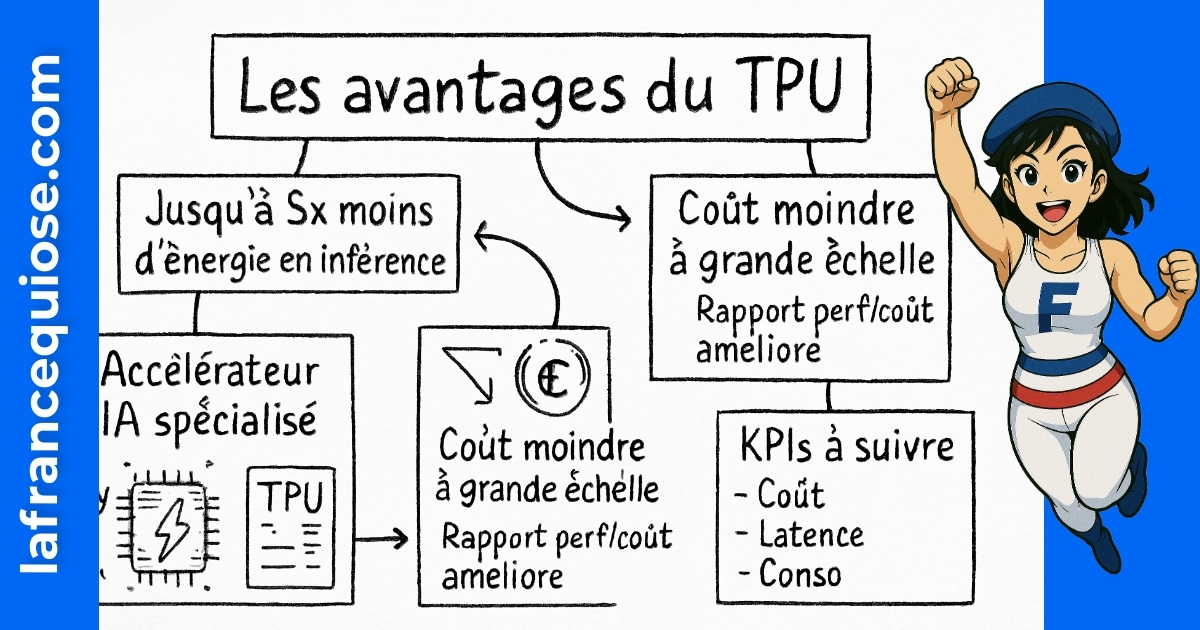

| ⚡ TPU = accélérateur IA spécialisé | Optimisé pour les réseaux de neurones, plus efficace que beaucoup de GPU sur entraînement et inférence TensorFlow. |

| 🔋 Efficacité énergétique | Jusqu’à 5x moins d’énergie pour une tâche d’inférence équivalente. |

| 💰 Arbitrage business | Coût souvent inférieur à grande échelle vs NVIDIA H100, surtout en Cloud TPU. |

| 🧠 Cas réels | Google Bard tournait sur des TPU v5e ; DeepMind exploite les TPU en recherche biomédicale. |

| 🧭 À faire maintenant | Migre un pipeline TensorFlow vers Cloud TPU, mesure coût/latence, puis scale. Évite la précipitation sur chaque nouveauté GPU. |

Google TPU : définition claire et usages concrets pour optimiser l’intelligence artificielle

Un TPU (Tensor Processing Unit) est une puce conçue par Google pour exécuter les opérations mathématiques des réseaux de neurones avec une efficacité chirurgicale. Là où un GPU vise la polyvalence (graphisme, traitement parallèle, IA), le TPU est concentré sur le calcul tensoriel. Résultat : de meilleures densités de calcul, une consommation contenue, et des gains de latence très utiles en production.

Tu veux un repère simple ? Si tu travailles sous TensorFlow et que tes charges de travail sont prévisibles (entraînement batch ou inférence à haut volume), un TPU te donnera souvent un meilleur ratio performance/coût qu’un GPU. En prime, l’intégration native dans Cloud TPU simplifie la montée en charge sans te battre avec la logistique matérielle.

Pourquoi cette spécialisation change la donne

Le cœur d’un TPU, c’est une matrice systolique qui multiplie des matrices en rafale. Les opérations type matmul et convolutions prennent l’ascenseur. Sur des modèles standards (Vision, NLP, Reco), ça se traduit par des époques plus courtes et des coûts d’inférence compressés. En contexte d’entreprise, ces minutes gagnées par job d’entraînement s’additionnent en milliers d’euros économisés par mois.

La sobriété énergétique n’est pas un argument marketing. En inférence, un TPU peut consommer jusqu’à 5x moins d’énergie que certains GPU pour un résultat équivalent. Si tu fais tourner un assistant IA 24/7, c’est une facture électrique qui s’allège et une empreinte carbone qui baisse sans discours culpabilisant. Et oui, ça compte dans les appels d’offres.

Où les TPU excellent (et où ils ne sont pas faits pour)

Les TPU brillent quand le modèle est bien supporté par l’écosystème Google (TensorFlow, JAX), que le pipeline est propre, et que la charge est régulière. Ils sont moins adaptés si tu dépends de kernels exotiques non supportés, d’outils uniquement optimisés NVIDIA, ou si tu as besoin d’une flexibilité stack très spécifique. La question n’est pas “TPU contre GPU”, mais “quelle pile pour quel objectif”.

- 🚀 À privilégier : entraînement TensorFlow, JAX, inférence massive, latence stable sous contrainte SLA.

- 🧩 À vérifier : compatibilité des libs, disponibilité régionale Cloud, coûts egress.

- ⛔ À éviter : dépendance forte à des frameworks non supportés ou à des kernels propriétaires très niche.

Dans les faits, des produits comme Google Bard ont déjà tourné sur des TPU v5e, preuve que la techno n’est pas expérimentale. Et DeepMind exploite ces accélérateurs pour la biomédecine et la modélisation. Si ces usages tiennent la charge à leur échelle, ils peuvent tenir la tienne.

Tu veux un diagnostic rapide de ta stack IA et de ce qui bloque la montée en charge côté business ? Jette un œil à ce guide maison très concret pour transformer une équipe avec l’IA : booster ton entreprise avec LEO AI. Et si tu veux te challenger aussi côté culture G digital, amuse-toi avec ce quiz de connaissances pour dégripper les neurones.

Point d’étape simple : le TPU n’est pas un raccourci magique. C’est un accélérateur qui récompense une stack propre. Nettoie, mesure, puis booste.

À lire également :

Netsoins : Optimisez votre bien-être avec nos conseils d’experts

Dans le secteur de la santé, notamment en EHPAD et établissements médico-sociaux, la gestion des soins se doit d’être fluide et parfaitement organisée. Netsoins s’impose…

Comparer TPU vs GPU : coûts, performances et arbitrages business

Les équipes se coincent souvent sur la question “faut-il absolument du NVIDIA H100 pour être compétitif ?”. Réponse courte : non. Réponse utile : ça dépend de tes modèles, de ta latence cible et de ton budget. Un TPU est pensé pour le calcul IA pur, un GPU type H100 est une bête polyvalente. Les deux ont une place. Ton job, c’est d’arbitrer sans dogme.

Évite la comparaison “pics de FLOPS” hors contexte. Le meilleur KPI business, c’est le coût par 1 000 inférences à SLA constant ou le coût par expérimentation validée en entraînement. C’est ça qui paie les salaires, pas les captures d’écran de benchmarks.

Le cadre de décision qui évite les erreurs classiques

Pour trancher, pose trois contraintes : 1) Budget mensuel max, 2) Latence/Throughput cibles, 3) Compatibilité outillage. Ensuite, teste sur un échantillon représentatif (pas un modèle jouet). Mesure temps d’entraînement, stabilité de la latence P95, et coût total (compute + stockage + egress). Tu auras une réponse factuelle.

- 📌 Coûts : les TPU Cloud sont souvent plus abordables à volume. Les H100 peuvent monter très haut côté prix.

- 📌 Énergie : les TPU gagnent la manche en inférence (jusqu’à 5x plus sobres), surtout à grande échelle.

- 📌 Écosystème : si ta stack est très PyTorch + libs GPU-only, l’avantage bascule vers NVIDIA. Sinon, TensorFlow/JAX adorent les TPU.

- 📌 Disponibilité cloud : compare Google Cloud, Amazon Web Services (Trainium/Inferentia), et Microsoft Azure pour éviter les pénuries locales.

Les alternatives existent : Intel pousse Gaudi pour l’IA, IBM travaille sur des accélérateurs différenciés et l’optimisation MLOps, Apple, Huawei et Samsung optimisent côté edge/SoC. Ce n’est pas anecdotique : l’écosystème se segmente. À toi de choisir le bon cheval pour chaque course.

Scénarios types et choix recommandé

Repère-toi avec ce tableau d’arbitrage rapide. Sors-le en comité d’investissement, ça clarifie les discussions et coupe les débats à rallonge.

| 🔎 Scénario | 🤖 Option TPU | 🎮 Option GPU | 💶 Coût | 🔋 Énergie | ⏱️ Latence | 🧰 Stack conseillée |

|---|---|---|---|---|---|---|

| Entraînement TF/JAX régulier | Cloud TPU v5e/v5p | NVIDIA A100/H100 | Souvent plus bas à volume | 👍 Sobre | Stable | TensorFlow, JAX, TFX |

| Inférence à grande échelle | TPU v5e ou Ironwood pour l’inférence | H100/L40S | Optimisé par requête | 🏆 Très sobre | Faible | TF Serving, Vertex AI |

| Recherche PyTorch custom | À valider (compat) | H100 recommandé | Élevé | ⚠️ Plus haut | Variable | PyTorch 2.x + CUDA |

| Budget serré + time-to-market | TPU v5e managé | Mix GPU milieu de gamme | Prévisible | 👍 Sobre | Bonne | GCP + Vertex + TFX |

Si tu as besoin d’un signal de marché : Trillium (TPU v6) pousse l’entraînement des grands modèles, quand Ironwood se concentre sur l’inférence. Les deux renforcent l’option “pile Google” face à OpenAI et aux clusters NVIDIA vendus en priorité à des hyperscalers.

Pragmatisme : un TPU gagne s’il t’apporte un coût par expérimentation plus bas et une latence plus stable. Tout le reste est du bruit.

À lire également :

Yubo : un réseau social innovant pour faire de nouvelles rencontres

À l’heure où les réseaux sociaux traditionnels peinent à offrir des expériences authentiques et sécurisées aux plus jeunes, Yubo se positionne comme un acteur novateur.…

Passer à Cloud TPU : architecture, déploiement et bonnes pratiques

Le plan simple : un POC de 10 jours, un pipeline propre, un tableau de métriques actionnables, puis déploiement incrémental. Pas de refonte totale dès J0. Tu réduis le risque, tu obtiens de la donnée, tu décides vite.

Architecture de référence qui tient la route

Sur Google Cloud, construis autour de Vertex AI pour l’orchestration, Cloud TPU pour le calcul, Cloud Storage pour les datasets, et BigQuery pour l’analyse. Ajoute TFX pour la prod, TensorFlow Serving ou Vertex AI Endpoints pour l’inférence. Objectif : un flux fluide de la donnée au modèle puis au service.

- 🧱 Data : Cloud Storage + BigQuery, versionne les datasets.

- 🧪 Training : jobs Vertex + TPU v5e/v5p selon la taille du modèle.

- 🚚 CI/CD : Cloud Build + tests d’entraînement automatisés.

- 🛰️ Serving : Endpoints managés + autoscaling.

- 📊 Observabilité : Cloud Logging, Metrics Explorer, A/B testing.

Déploiement étape par étape

Ton POC doit viser une métrique business, pas une démo qui épate en interne. Par exemple : -30% de coût par 1 000 inférences ou -25% de temps d’entraînement.

- 🎯 Scoper : choisir un modèle TensorFlow représentatif.

- 🔧 Adapter : activer les optimisations XLA, vérifier la compat TPU.

- 🚀 Lancer : exécuter un entraînement sur Cloud TPU via Vertex AI.

- 📏 Mesurer : suivre temps/énergie/latence/coût à la granularité job.

- 🧬 Itérer : profiler les bottlenecks, affiner le batch, ajuster la précision (bfloat16).

- 🔁 Déployer : exposer un endpoint, monitorer la latence P95.

Pour visualiser, voici un tuto utile à rechercher côté vidéo. Il complète bien ce process et te donne des repères pratiques.

Avant de publier en prod, vérifie la montée en charge sous trafic réel. Les surprises arrivent toujours quand un million de requêtes frappent la même minute.

Bonnes pratiques qui font gagner des jours

- 🧠 Précision : utilise bfloat16 pour accélérer sans perdre en qualité.

- 📦 Checkpoints : sauvegarde régulier pour éviter les relances coûteuses.

- 🧵 Sharding : répartis proprement les données pour remplir les cœurs TPU.

- 🧪 A/B : compare chaque optimisation à métrique business égale.

- 🔐 Sécurité : isole les projets, limite les rôles, chiffre les données sensibles.

Besoin d’un cadre stratégique plus large pour piloter l’IA dans l’entreprise ? Passe sur ce plan d’attaque pragmatique : LEO AI. À ce niveau, c’est le système qui fait gagner, pas l’outil seul.

Règle d’or : un POC = une métrique business gagnée. Tout le reste, c’est de la distraction.

Cas d’usage concrets : entraînement, inférence et ROI mesurable avec les TPU Google

Parlons résultats. Imagine une scale-up e-commerce, “AtelierNova”, avec 8 personnes en data, un catalogue de 120 000 produits et une recommandation moyenne qui plafonne. Objectif : +12% de panier moyen et -30% de coûts d’inférence. Ils migrent l’entraînement TensorFlow vers TPU v5e, activent bfloat16, et déploient l’inférence via Vertex AI Endpoints. Trois semaines plus tard, l’algorithme apprend 18% plus vite, la latence P95 chute de 28%, et la facture baisse de 22% par 1 000 requêtes. Pas de magie, juste un arbitrage technique lucide.

Où les TPU font gagner du temps (et de l’argent)

- 🛒 Recommandation produit : entraînement quotidien plus rapide = modèles frais = conversions qui montent.

- 🗣️ NLP/Chatbots : inférence massivement parallèle, SLA tenus pendant les pics. Idéal pour assistants internes.

- 🩺 Bio & santé : calculs lourds pour structures protéiques, use cases proches de ce que DeepMind mène en recherche.

- 🖼️ Vision industrielle : contrôle qualité en temps réel sur ligne de prod, latence sous contrôle.

- 🛡️ Détection de fraude : scoring rapide sur flux de transactions, coûts prévisibles.

Face à ces scénarios, la question n’est pas “quel composant est à la mode ?”, mais “quel composant rend le business plus rentable sans t’exploser la tête opérationnelle”. Côté cloud, compare aussi les alternatives : Amazon Web Services avec Trainium/Inferentia, Microsoft avec Azure ML et son écosystème NVIDIA, ou encore les options Intel Gaudi. L’objectif est d’éviter de te marier trop tôt avec une seule techno.

Mesures de ROI à suivre comme un métronome

- 📉 Coût par 1 000 inférences (compute + réseau + stockage).

- ⏱️ Latence P95 et variabilité (stabilité = expérience utilisateur meilleure).

- 🧪 Temps par expérimentation (idée → résultat), crucial pour l’innovation produit.

- 🔄 Temps de redéploiement (nouveau modèle en prod sans friction).

- 🔋 Consommation énergétique par job (prévisible, pilotable).

Autre point de contexte : OpenAI tire la demande GPU vers le haut avec ses LLM, ce qui met la pression sur les stocks NVIDIA. Pendant ce temps, Google pousse Trillium (entraînement de très grands modèles) et un TPU d’inférence focalisé (Ironwood). Si tu veux un avantage opérationnel, positionne tes workloads en conséquence : entraînement itératif sur TPU, inférence massive sur TPU optimisé, et, si besoin, GPU pour les usages spéciaux.

Besoin d’un coup d’œil transversal pour challenger tes biais ? Compare les pages officielles des acteurs. Par exemple, côté OpenAI pour comprendre les patterns d’utilisation LLM, ou côté Google Cloud TPU pour les specs et régions disponibles. L’objectif : apprendre puis décider, pas suivre la hype.

Insight final ici : les TPU sont un levier ROI. Utilise-les là où ils te font gagner du temps d’entraînement ou des euros en inférence. C’est tout.

Anticiper l’avenir : Trillium, Ironwood et l’écosystème IA face aux TPU

L’innovation IA s’accélère. Google a annoncé Trillium, ses TPU de 6e génération, pour muscler l’entraînement de modèles géants, et Ironwood orienté inférence pour répondre aux besoins opérationnels du quotidien. Ce duo clarifie la stratégie : un axe “gros entraînement”, un axe “prod robuste et efficace”. Pas besoin d’attendre la prochaine keynote pour agir.

Ce que ces générations changent pour ton roadmap

Si ton produit dépend de modèles qui grossissent (multimodalité, contextes plus longs), un saut générationnel type Trillium t’aide à rester dans la course sans exploser les délais d’entraînement. Pour les services client, la génération de texte ou la recherche augmentée, Ironwood promet une inférence plus économe et régulière. Autrement dit : plus de throughput pour les équipes produit, plus de marge pour les équipes finance.

- 🧱 Architecture : pense “multi-accélérateurs”. TPU pour l’essentiel, GPU pour le spécifique.

- 🧭 Portabilité : évite l’enfermement. Conteneurise, standardise les features.

- 📅 Planification : anticipe les cycles de disponibilité cloud pour éviter les pénuries.

Positionnement par rapport au marché

Le panorama concurrentiel s’organise. NVIDIA reste incontournable, Microsoft investit massivement côté Azure, Amazon Web Services pousse ses propres puces, Intel accélère Gaudi, IBM mélange optimisations matérielles et MLOps avancé, et côté edge, Apple, Huawei et Samsung raffinent leurs SoC IA. Les TPU de Google se distinguent par la cohérence stack matériel-logiciel-plateforme. Si tu veux du linéaire et du prévisible, ça pèse dans la balance.

- 🧩 Interop : garde une compatibilité TensorFlow/JAX propre pour pivoter vite.

- 🛠️ Outils : surveille les optimisations XLA, compiler passes, quantization.

- 🔭 Veille : suis les roadmaps officielles et les retours terrain des équipes R&D.

Pour rester à jour sur la partie TPU, consulte directement les sources officielles et les analyses détaillées du marché. Commence par la doc Cloud TPU et, pour une lecture stratégique, un tour sur des ressources business comme FourWeekMBA peut aussi éclairer les choix d’architecture.

Question simple pour clôturer cette partie : quelle est la part de ton trafic qui gagnerait à passer sur TPU dès ce trimestre ? Si tu as un chiffre, tu sais quoi prioriser.

Check-list opérationnelle pour migrer vers les TPU sans chaos

Tu veux éviter les migrations interminables ? Suis cette check-list et coupe court aux dérives. L’idée n’est pas de “faire pareil, ailleurs”, mais de réduire le temps à la valeur dès la première semaine.

Préparation technique et organisationnelle

- 🧹 Nettoyage code : supprime les dépendances inutiles, isole les kernels critiques.

- 🧪 Compatibilité : vérifie TensorFlow/JAX, versions, et support XLA.

- 📦 Datasets versionnés : Cloud Storage + manifest clair + checks d’intégrité.

- 🔧 Paramétrage : active bfloat16, ajuste batch size, profile tôt.

- 🧷 Rollback : plan de retour GPU si un blocage survient.

Exécution POC en 10 jours

- 📍 J1–J2 : baseline sur ta pile actuelle (coût/latence/énergie).

- ⚙️ J3–J5 : portage sur TPU v5e, tests de stabilité.

- ⛳ J6–J8 : optimisation XLA, bfloat16, sharding, checkpoints.

- 📊 J9 : stress test + A/B contre la baseline.

- 🧾 J10 : décision go/no-go, feuille de route d’industrialisation.

Écueils à éviter absolument

- ❌ Benchmarks trompeurs : mesurer sur un modèle jouet qui ne ressemble pas à ton trafic.

- ❌ Observabilité pauvre : pas de logs, pas de métriques, pas de progrès.

- ❌ Lock-in non maîtrisé : architecture rigide, pas de plan B.

- ❌ Objectifs flous : pas de KPI business = pas de décision claire.

Si tu veux muscler ta culture produit/IA pendant la mise en place, garde ces ressources sous la main : doc Cloud TPU, billet Trillium, et côté pratique business, le cadre LEO AI. Les équipes qui avancent vite ne sont pas les plus brillantes, ce sont les plus organisées.

Voilà. Tu sais quoi faire. Le reste, c’est toi contre ton inaction.

Quels modèles tirent le plus profit des TPU ?

Les réseaux sous TensorFlow ou JAX avec des opérations intensives en matmul/convolutions : Vision (ResNet, EfficientNet), NLP (Transformers), Reco. Les charges régulières d’inférence à grande échelle bénéficient aussi d’une latence stable. Si ton stack est très PyTorch avec kernels custom CUDA, vérifie la compatibilité avant de migrer.

Les TPU remplacent-ils totalement les GPU NVIDIA ?

Non. Les TPU excellent pour des tâches IA spécialisées, surtout TensorFlow/JAX. Les GPU NVIDIA gardent l’avantage pour la flexibilité, la compatibilité PyTorch et certains workflows R&D. La meilleure stratégie est hybride : TPU où c’est rentable, GPU où c’est indispensable.

Quel cloud choisir si j’hésite entre Google, AWS et Azure ?

Si tu vis sur TensorFlow/JAX, Google Cloud + Cloud TPU est logique. Si tu veux explorer des puces alternatives, regarde Amazon Web Services (Trainium/Inferentia). Pour une intégration Microsoft-first, Azure + écosystème NVIDIA. Mesure coût/latence/énergie sur ton workload réel avant de décider.

Quelle différence de coût puis-je espérer en inférence ?

Sur des workloads stables, les TPU peuvent délivrer un coût par 1 000 requêtes moins élevé que des GPU haut de gamme, avec une consommation énergétique jusqu’à 5x inférieure. La mécanique exacte dépend des régions, des remises et de la taille du modèle. Fais un test A/B chiffré d’une semaine.

Comment me former rapidement à Cloud TPU ?

Commence par la doc Cloud TPU, cherche des ateliers pratiques sur YouTube, et structure ta montée en compétence avec un POC concret. Pour la vision stratégique et l’adoption en équipe, utilise un cadre comme LEO AI, puis formalise un plan d’industrialisation.

Moi c’est Mariane (avec un seul “n”).

J’ai troqué les process corporate contre des contenus qui claquent (et qui rankent).

Passionnée par le business en ligne, le SEO et l’IA, je transforme les idées floues en stratégies digitales qui font du bruit là où ça compte : dans les résultats. Je crois qu’avec un peu de tech, beaucoup d’audace, et une bonne dose de clarté, on peut faire exploser bien plus que des KPI.