Les modèles d’IA grossissent, les budgets GPU explosent et les délais de mise en production s’allongent. L’élagage, bien mené, remet de l’ordre : tu coupes le gras, tu gardes la performance, tu paies moins et tu livreras plus vite.

| Habitué au story des 15 secondes ? Voilà ce que tu dois retenir : 📌 | 🧠 Résumé actionnable |

|---|---|

| ✅ Point clé #1 ⚡ | L’élagage supprime les poids inutiles pour rendre le modèle plus rapide et sobre sans sacrifier la précision. |

| ✅ Point clé #2 🛠️ | Combine pruning itératif + quantization pour des gains x2 à x4 sur l’inférence, surtout sur mobile et edge. |

| ✅ Point clé #3 ⛔ | Évite de couper “au jugé” : mesure chaque étape, recalibre, réentraîne si besoin. La dérive de précision coûte plus cher que quelques millisecondes gagnées. |

| ✅ Point clé #4 📉 | Exemples concrets : BERT élagué = +50 % de vitesse pour ~95 % de précision conservée ; GPT-3 optimisé = -30 % de calcul. |

Techniques d’optimisation de l’IA : l’élagage pour des modèles plus rapides et sobres

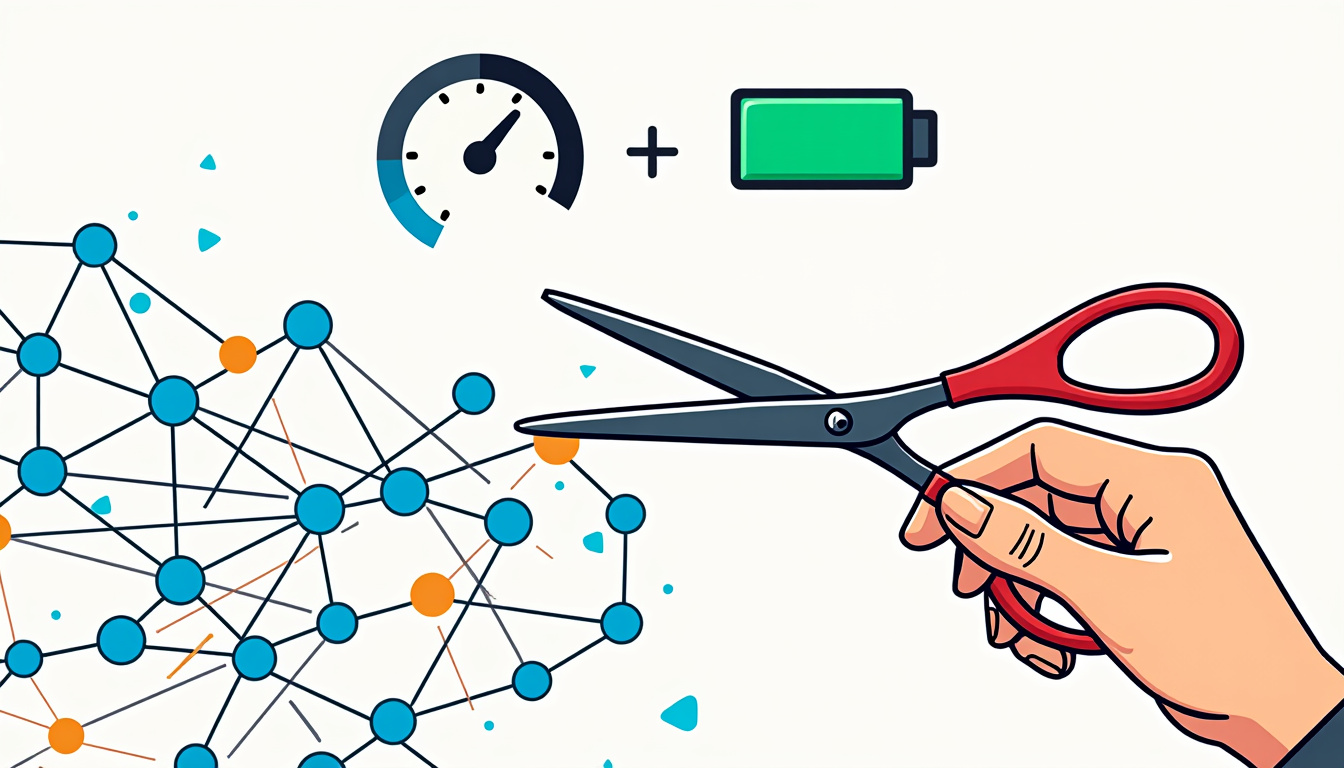

L’élagage (pruning) est simple à comprendre et stratégique à exécuter : tu supprimes les connexions et neurones qui ne servent quasiment à rien pour réduire la taille, accélérer l’inférence et économiser l’énergie. Sur un modèle de NLP standard, enlever 40 % des poids peu contributifs peut abaisser la latence de 30 à 60 % selon l’architecture et le matériel.

En 2025, ce n’est plus un nice-to-have. C’est un levier économique. Les coûts d’inférence pèsent sur le CAC et sur la marge. L’élagage permet de faire rentrer l’IA dans un EcoModèle viable : mêmes résultats, moins de ressources. Tu as des serveurs partagés, des KPI de disponibilité, des SLAs à tenir ? Le pruning est ton amortisseur.

Trois approches dominent. Le pruning structuré retire des blocs entiers (filtres, têtes d’attention, canaux), ce qui accélère vraiment sur GPU/TPU car le graphe se simplifie. Le pruning non structuré supprime des poids isolés (sparsité fine), pratique pour atteindre des taux élevés d’élagage, surtout couplé au support matériel de sparsité (ex. motifs 2:4). Enfin, le pruning itératif te permet de couper progressivement, de réentraîner et de stabiliser la précision.

Tu veux du concret ? Des versions élaguées de BERT ont déjà montré des accélérations de +50 % avec ~95 % de la précision conservée sur des benchmarks populaires. Des déclinaisons de GPT-3 optimisées via pruning et quantification affichent -30 % de calcul tout en restant pertinentes pour des tâches de génération/inférence. Les chiffres varient selon les jeux de données, mais la tendance est claire : “moins” peut vraiment rimer avec “mieux”.

Deux erreurs à éviter : couper trop vite et ne pas mesurer. Sans métriques, tu confonds vitesse perçue et gain réel. Mesure la latence P95, la consommation VRAM, le taux d’échec et la drift de précision. Si tu déploies sur mobile, vérifie la chauffe et l’autonomie.

- 🚀 Objectif business : réduis la latence P95 d’au moins 30 % avant d’augmenter le trafic.

- 📦 Cible déploiement : edge et mobile avec modèles allégés (SlimCore, NoyauVif).

- 🧪 Méthode : pruning itératif + réentraînement court pour réparer la précision.

- 🔧 Stack utile : PruneAI, OptiRéseau, LightnerIA pour l’automatisation.

- 🌱 Impact : passage à un EcoModèle qui consomme moins sans rogner sur l’expérience.

Le bon réflexe : traite l’élagage comme un chantier d’optimisation continue, pas comme un “coup de ciseau” unique.

À lire également :

À la rencontre de Thomas Plantenga, un innovateur au parcours inspirant

Thomas Plantenga a redressé Vinted en misant sur une stratégie produit sans fioritures, un marketing mesurable et un culte de l’exécution. Son parcours n’inspire pas…

Comprendre la différence : élagage neuronal structuré et non structuré

Deux écoles, deux effets sur la vitesse. L’élagage structuré supprime des unités cohérentes (ex. canaux de convolution, têtes d’attention, blocs entiers). Résultat : un graphe plus petit, mieux parallélisable, des accélérations nettes sur GPU/TPU/CPU. L’élagage non structuré enlève des poids individuels selon leur “faible magnitude”. Résultat : une forte sparsité mais un graphe identique, donc le gain de vitesse dépend du support matériel et des libraries (sparsité 2:4, kernels spécialisés). Les deux sont compatibles et souvent complémentaires.

Cas réel. Une scale-up e-commerce a réduit de 35 % la latence sur ses recommandations produit en coupant 25 % de canaux sur 3 couches CNN (structuré) puis en appliquant 30 % de sparsité fine (non structuré). Pourquoi ça marche ? Parce que le structuré enlève le ballast visible, le non structuré affine la coupe.

Quand choisir quoi ? Si tu vises le déploiement embarqué (Core ML, NNAPI, WebNN), préfère le structuré : la taille du graphe prime. Si tu exploites des GPU avec support de sparsité matérielle, le non structuré devient pertinent, surtout avec un motif régulier (2:4) qui déclenche les accélérations natives.

Ne confonds pas vitesse et légèreté. Un modèle très sparse peut être léger sur disque mais pas forcément plus rapide si les kernels ne suivent pas. À l’inverse, enlever des filtres entiers impacte tout le pipeline (moins d’activation, moins d’opérations), donc un gain plus constant.

Approche hybride efficace

La combinaison la plus rentable reste une stratégie hybride en trois temps : (1) structuré pour retirer les zones dormantes, (2) non structuré pour lisser les extrêmes, (3) réentraînement court pour remonter la précision. Termine avec une quantization (8 bits voire 4 bits selon tolérance) et tu obtiens un modèle réellement taillé pour l’inférence.

- 🧩 Structuré → retire des blocs, simplifie le graphe, accélère partout.

- 🌿 Non structuré → crée de la sparsité fine, réduit la mémoire.

- 🔁 Itératif → coupe par paliers (10–20 %) et contrôle la dérive.

- 🎯 Post-traitement → quantize, fusionne les couches, exporte en ONNX.

Prends l’exemple d’un BERT base pour classification. Supprime 2 têtes d’attention par couche sur 4 couches (structuré), puis applique 30 % de sparsité non structurée avec un critère L1. Réentraîne 2 à 3 epochs avec un learning rate réduit, et tu atteins souvent un sweet spot : latence divisée par 1,4 à 1,6 avec moins de 2 points de perte d’accuracy sur des datasets textuels standards.

Tu doutes encore ? Regarde les mesures sous contrainte de SLA. Sous 200 ms de P95, le structuré offre un chemin fiable. Une fois le graphe resserré, la couche non structurée s’occupe des finitions. C’est cette logique que des outils comme Élagence, RaffinIA ou SculpteurLogique automatisent avec des politiques de coupe pilotées par la métrique d’impact (perte de validation, SNR, sensibilité de couche). Insight clé : mélange les approches, mais garde la rigueur du contrôle qualité.

À lire également :

Découvrez les meilleurs livres résumés avec Headway Premium pour seulement 45 £

La lecture est un des piliers essentiels pour booster l’esprit, enrichir ses connaissances et affûter son développement personnel. Pourtant, dans un monde où le temps…

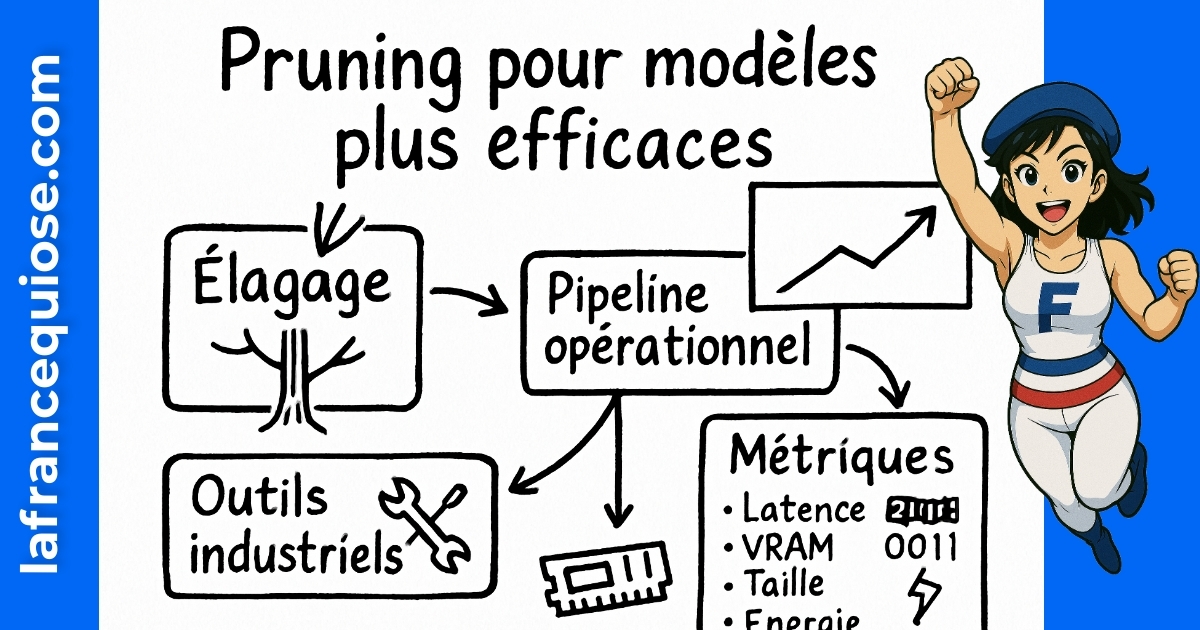

Élagage des réseaux neuronaux : méthode opérationnelle et métriques qui comptent

Pas de miracle, juste une procédure claire. L’élagage exige une boucle mesure → coupe → réentraîne → valide. Sans discipline, tu abîmes ton modèle. Avec méthode, tu sors un NoyauVif prêt pour la prod.

Pipeline prêt à déployer

Commence par un profilage précis : identifie les couches qui saturent la latence (conv lourdes, MLP géants, têtes d’attention). Fixe un objectif métrique (ex. -40 % de latence P95, -30 % de RAM, -20 % d’énergie). Établis un calendrier d’élagage (10 % par itération, 3 à 5 itérations), et sélectionne le critère de coupe (norme L1/L2, sensibilité de couche, importance des gradients).

- 🧭 Étape 1 — Profiler les goulots d’étranglement (latence par couche, FLOPs, paramètres) 💡

- ✂️ Étape 2 — Couper par paliers (structuré d’abord, non structuré ensuite) 🪚

- 🔁 Étape 3 — Réentraîner court (2–5 epochs) pour stabiliser 🎯

- 🧪 Étape 4 — Valider en conditions réelles (batchs variés, trafic mixte) 🧪

- 📦 Étape 5 — Exporter (ONNX, TensorRT, Core ML) et bench matériel ⚙️

Sur le plan industriel, documente le diff de performance par version. Ce suivi montre où la coupe se paye et où elle commence à coûter. Des plates-formes comme PruneAI ou OptiRéseau orchestrent ces cycles avec des tableaux de bord pour latence, précision et coûts d’inférence.

Métriques qui importent vraiment

Tes indicateurs doivent refléter l’usage réel. Priorise la latence P95/P99, la consommation VRAM, la taille binaire et l’impact énergétique par requête. Pour la précision, surveille l’accuracy/F1/ROUGE/BLEU selon la tâche, mais regarde aussi la robustesse (sensibilité au bruit) et la stabilité sur des data shift. Si tu vois une dérive > 2 pts sur ton KPI métier, réduis le taux de coupe ou augmente l’entraînement de récupération.

| ⚙️ Composant | 🧪 Indicateur clé | 📈 Cible raisonnable | 🧰 Outils (exemples) | 💡 Astuce |

|---|---|---|---|---|

| Convolutions | Latence P95 par couche | -30 à -50 % | LightnerIA, TensorRT | Pruning structuré par canaux pour gains réels 🚀 |

| Attention | FLOPs et heads actives | -20 à -40 % | Élagence, ONNX Runtime | Supprime heads peu contributives 🎯 |

| MLP | Taille binaire | -25 à -60 % | RaffinIA, SlimCore | Sparsité non structurée + quantization 🧮 |

| Embeddings | RAM/VRAM | -15 à -35 % | EffiTrim | Prune indices rares + partage de poids 🔗 |

| Pipeline | Conso énergétique | -20 à -40 % | EcoModèle toolkit | Mesure Wh/req en prod 🌱 |

Case study express. “StudioVid”, une plateforme vidéo, a réduit ses coûts d’inférence de 28 % en 3 semaines : pruning structuré des couches lourdes, sparsité 30 %, quantization int8, et déploiement TensorRT calibré. Le tout orchestré via OptiRéseau et SlimCore pour la CI. Résultat : P95 passée de 220 ms à 145 ms, budget GPU aligné avec la croissance.

Règle simple pour avancer sans trembler : coupe peu, mesure fort, répare vite.

Moins, c’est plus : déployer des modèles élagués sur mobile et edge sans perdre en précision

La vraie bataille se joue au moment du déploiement. Un modèle élagué qui performe en notebook mais stresse en prod ne sert à rien. Sur mobile et edge, la contrainte est triple : latence, mémoire, énergie. L’élagage coche ces trois cases, surtout combiné à la quantization et aux optimisations runtime (fusion d’opérations, kernels spécialisés).

Sur les GPU modernes, la sparsité 2:4 bénéficie d’un support matériel. Résultat : les matrices creuses ne sont plus un handicap, elles deviennent un levier. Côté Apple/Android, l’export Core ML et NNAPI profite des graphes simplifiés. Pour le web, WebNN commence à absorber ces gains. Bref, l’élagage structuré facilite partout la vie des runtimes.

Exemple terrain. “KlioFit”, application de coaching sportif, devait passer d’un modèle de détection de mouvements à 50 FPS sur un smartphone milieu de gamme sans vider la batterie. Plan d’attaque : pruning structuré des convolutions (−35 % de canaux), sparsité non structurée (25 %), quantization int8, puis export ONNX → Core ML. Résultat : +48 % de FPS, -22 % de chauffe moyenne, pas de baisse perceptible pour l’utilisateur. L’équipe a aussi adopté EffiTrim pour compacter les embeddings et NoyauVif pour bench automatique.

- 📱 Mobile-ready : privilégie structuré pour des graphes plus petits et des inferencers heureux.

- 🔌 Énergie : vise -25 % Wh/requête en couplant pruning + int8.

- 🧩 Compatibilité : vérifie opset ONNX et les fusions supportées par TensorRT/Core ML.

- 🛡️ Robustesse : teste sous conditions réelles (réseau instable, batterie faible, multitâche).

- 🎛️ Opérations : bloque les régressions via des tests de non-régression CI/CD.

Outilbox concrète. PruneAI pour définir les politiques de coupe, SlimCore pour automatiser les exports et la validation cross-runtime, LightnerIA pour profiler la latence en environnement réel, et EcoModèle pour suivre la consommation énergétique. Ajoute RaffinIA pour gérer les “fine-tunes” post-élagage sans casser ton historique d’expériences.

Vision stratégique : l’élagage n’est pas une coquetterie technique, c’est une condition d’échelle. Tu veux multiplier les endpoints et tenir le pic trafic sans doubler la facture ? Coupe. Ensuit, teste. Puis n’arrête jamais le cycle d’optimisation. Le coût se contrôle, la qualité se défend, la vitesse se gagne.

Feuille de route 30 jours : de ton modèle lourd à un NoyauVif prêt pour la prod

Tu veux un plan clair, réalisable sans excès de blabla. Voici une feuille de route qui tourne en 30 jours, orientée résultats et gouvernance des risques. L’objectif : sortir un modèle NoyauVif, affûté, mesuré, et facile à maintenir.

Semaine 1 — Diagnostic et objectifs

Audit complet : latence par couche, empreinte mémoire, FLOPs, trafics cibles. Fixe des objectifs chiffrés réalistes (ex. -40 % P95, -30 % RAM, -20 % Wh/req). Définis le périmètre fonctionnel non négociable (métrique métier, tolérance de dérive). Équipe ton pipeline avec OptiRéseau pour tracer chaque essai.

- 📊 Bench initial stable (seed, dataset figé, protocole clair).

- 🔍 Identification des couches “coûteuses”.

- 🎯 Cibles signées par l’équipe produit et data.

Semaine 2 — Coupe maîtrisée (structuré d’abord)

Attaque les zones lourdes : canaux des convolutions, têtes d’attention, blocs MLP. Coupe 10–20 % par itération. Après chaque passe, réentraîne 2–3 epochs avec LR réduit. Valide la précision et la robustesse (bruit, perturbations réalistes). Utilise Élagence et LightnerIA pour piloter et mesurer.

- ✂️ 2–3 itérations max en structuré.

- 🧪 Validation croisée sur échantillons difficiles.

- 🧯 Rollback clair si dérive > 2 pts.

Semaine 3 — Finitions (non structuré) et quantization

Applique une sparsité non structurée 20–40 % selon tolérance. Stabilise par un fine-tune court. Enchaîne avec quantization int8 (ou 4 bits si la tâche est plus permissive). Bench sur ton matériel cible (GPU, CPU, NPU mobile) et vérifie les gains réels. Outils : RaffinIA, EffiTrim, SlimCore.

- 🧮 Calibrage quantization sur un set représentatif.

- 📦 Export ONNX/TensorRT/Core ML et tests de compatibilité.

- 🔐 Tests de non-régression automatiques.

Semaine 4 — Durcissement prod et pilotage coûts

Déploie progressivement (canary). Mesure P95/P99, consommation, taux d’erreur, qualité perçue. Ouvre les vannes si OK. Mets en place des garde-fous (alertes sur dérive, budget GPU, latence). Formalise un runbook d’incident. Documente la stack (depuis les politiques de coupe jusqu’aux versions exportées) pour sécuriser la maintenance.

- 🚦 Canary sur 5–10 % de trafic, montée progressive.

- 💸 Tableaux de bord coûts vs performance.

- 📝 Documentation vivante (tests, seeds, versions).

Au bout de 30 jours, tu as un modèle plus rapide, plus sobre et plus rentable. Voilà. Tu sais quoi faire. Le reste, c’est toi contre ton inaction.

Questions fréquentes sur l’élagage des modèles d’IA

Quelle différence réelle entre gains disque et gains de latence ?

Réduire la taille binaire n’implique pas toujours un modèle plus rapide. Les gains de latence sont surtout obtenus avec de l’élagage structuré (réduction de canaux/blocs) et des runtimes compatibles. La sparsité fine accélère si le matériel et les kernels l’exploitent.

Jusqu’où couper sans dégrader la précision ?

Vise une coupe progressive (10–20 % par passe), valide à chaque étape, et réentraîne. Beaucoup de modèles tolèrent 30–50 % d’élagage total avec de perte sur des tasks standard, surtout avec un fine-tune court et de la quantization soignée.

Quels outils pour industrialiser le pruning ?

Pour automatiser : PruneAI (politiques de coupe), OptiRéseau (orchestration/CI), Élagence et RaffinIA (sélection fine), LightnerIA (profilage), SlimCore (exports), EffiTrim (embeddings), et EcoModèle (mesure énergétique).

Le pruning suffit-il ou faut-il d’autres techniques ?

Le combo gagnant, c’est élagage + quantization, souvent complété par distillation et low-rank. Ensemble, ces techniques maximisent les gains tout en préservant la qualité.

Moi c’est Mariane (avec un seul “n”).

J’ai troqué les process corporate contre des contenus qui claquent (et qui rankent).

Passionnée par le business en ligne, le SEO et l’IA, je transforme les idées floues en stratégies digitales qui font du bruit là où ça compte : dans les résultats. Je crois qu’avec un peu de tech, beaucoup d’audace, et une bonne dose de clarté, on peut faire exploser bien plus que des KPI.