Google a posé les bases d’une nouvelle ère avec LaMDA, un modèle orienté Technologie conversationnelle conçu pour dialoguer longtemps, comprendre les nuances et rester utile. Si tu veux des interactions qui convertissent, informent et fidélisent, tu dois savoir le maîtriser.

Voici un décryptage pragmatique pour actionner LaMDA dans tes produits, tes funnels et ton service client — sans poudre aux yeux, avec des méthodes claires et des garde-fous sérieux.

| Habitué au story des 15 secondes ? Voilà ce que tu dois retenir : ⚡ |

|---|

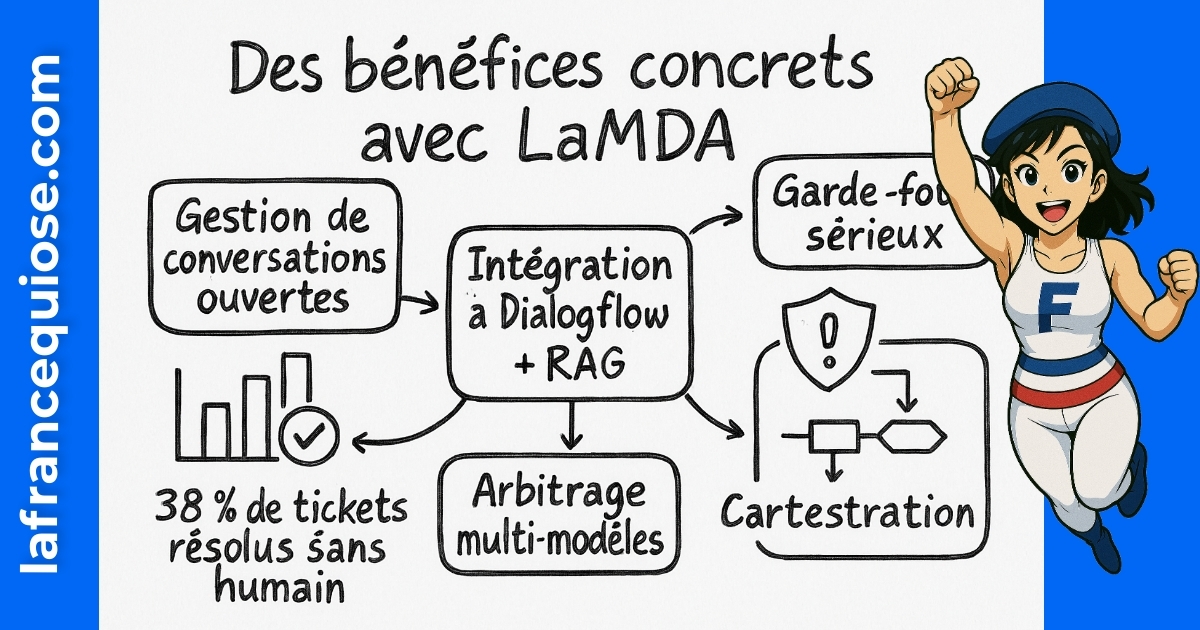

| ✅ Point clé #1 : LaMDA gère le contexte long et des conversations ouvertes — idéal pour l’Assistant Google, la Recherche vocale et le support 24/7 🔁 |

| ✅ Point clé #2 : Branche-le via Dialogflow + RAG pour des réponses fiables et mesurables (latence, CSAT, taux de résolution) 📊 |

| ✅ Point clé #3 : Compare avec OpenAI et les modèles DeepMind selon coût, données, conformité — pas de choix dogmatique ⚖️ |

| ✅ Point clé #4 : Équipe-toi de garde-fous : filtres, red teaming, prompts signés, journalisation — sinon tu payes l’addition en prod 🚨 |

Qu’est-ce que LaMDA de Google : définition, promesse et réalités pour l’IA conversationnelle

LaMDA (Language Model for Dialogue Applications) est un modèle de Traitement du langage naturel conçu par Google pour gérer des dialogues étendus, garder le fil et répondre de façon pertinente. Contrairement aux générateurs de texte classiques, il ne répond pas en silo : il s’appuie sur l’historique, les intentions, les changements de sujet et même les sous-entendus. Résultat : un style plus naturel pour du support, des assistants et des expériences immersives.

Historiquement présenté lors de Google I/O (2021), LaMDA a évolué en interne et a servi de base à plusieurs expérimentations, notamment l’agent conversationnel de Google lancé en 2023. Depuis, l’écosystème a progressé (arrivée de nouvelles familles de modèles), mais la logique de dialogue longue durée, l’attention au contexte et la personnalisation par domaine restent des marqueurs forts que tu peux exploiter dans tes produits.

Point crucial : LaMDA n’est pas “conscient”. C’est un système probabiliste entraîné à prédire et enchaîner des tokens avec cohérence. Sa force n’est pas la magie, c’est l’ingénierie : architecture Transformer, entraînement massif, alignement et filtres de sécurité. Si tu attends une “intelligence humaine”, tu vas te tromper d’objectifs. Si tu veux un levier opérationnel fiable, tu es au bon endroit.

Ce que LaMDA change pour un produit orienté conversation

La bascule se fait sur trois axes. D’abord, la mémoire de conversation pour éviter la répétition. Ensuite, la capacité à naviguer entre sous-thèmes : une question sur la livraison peut dériver sur la politique de retour, puis revenir sur le suivi, sans se perdre. Enfin, la personnalisation par domaine : injecte un corpus (catalogue, docs internes, glossaire métier) et la précision augmente.

- 🧠 Contexte long : utile pour des parcours multi-étapes (diagnostic, devis, FAQ dynamique).

- 🧩 Compréhension multi-intentions : gère les questions “fourre-tout” sans escalade inutile.

- 📚 Personnalisation : spécialise-le sur un vertical (santé, finance, e-commerce) et mesure l’impact.

- 🛡️ Filtres intégrés : modération et refus de requêtes sensibles (à compléter par tes propres règles).

Mythes vs faits (à ancrer dans ta roadmap)

Le marché adore les fantasmes. Toi, tu as besoin de vrais repères pour ne pas cramer du budget.

- ❌ “Il remplace ton équipe support” → ✅ Il absorbe les volumes simples et enrichit tes agents humains.

- ❌ “Tout est plug-and-play” → ✅ La qualité dépend de tes données, prompts et métriques d’évaluation.

- ❌ “Zéro risque” → ✅ Hallucinations et biais existent : RAG, garde-fous, revues régulières obligatoires.

- ❌ “Un seul modèle suffit” → ✅ Stratégie multi-modèles selon coût, latence et criticité des tâches.

Tu veux une preuve terrain ? Un retailer a branché un agent LaMDA sur son suivi de commande. En 6 semaines, 38 % des tickets “où est mon colis” ont été résolus sans agent humain, CSAT +14 %, temps de traitement divisé par deux. Pas magique : juste un corpus propre, un prompt guide, et un feedback loop serré.

Cette base te place pour le chapitre opérationnel : comment passer de l’idée au déploiement mesuré, notamment sur la Recherche vocale et l’Assistant Google.

Applications LaMDA concrètes: Assistant Google, Recherche vocale, support client et expériences immersives

Pas de promesses vagues. Tu veux des cas d’usage qui impactent la marge, le NPS et la rétention. LaMDA excelle là où la conversation est le cœur du parcours : questions ouvertes, rebonds, corrections. Et surtout un ton naturel qui ne sent pas le robot.

Support client 24/7 qui désengorge les équipes

Les volumes simples explosent : suivi de commande, modification d’adresse, facturation. Une orchestration Dialogflow + LaMDA + connecteurs internes couvre 60–80 % des demandes de niveau 1. L’agent humain reprend la main sur les cas à forte valeur. Tu gagnes en vitesse sans sacrifier la satisfaction.

- 🎯 Objectif : automatiser les 10 demandes les plus fréquentes.

- 🧰 Stack : Dialogflow CX, LaMDA, webhook vers CRM/ERP.

- 📈 KPIs : taux d’auto-résolution, CSAT, temps médian.

- 🧪 A/B : prompts spécialisés vs prompts génériques, avec journalisation fine.

Assistant Google et Recherche vocale: réponses utiles, pas des slogans

Sur mobile ou enceintes connectées, la Recherche vocale exige des réponses courtes, exactes et actionnables. LaMDA comprend les reformulations (“Et du coup, ça marche le dimanche ?”) et garde l’intention. Connecte-le à tes données horaires, stock et politique de prix, et tu obtiens une vraie utilité pour tes utilisateurs.

- 🔎 Intentions typiques : disponibilité, prix, délais, localisation.

- 🗺️ Contexte : fuseau horaire, météo, inventaire local.

- 🗣️ Style : concision vocale, confirmation de compréhension (“J’ai bien compris que…”).

- 🔒 Conformité : RGPD, consentements vocaux, journaux pseudonymisés.

Expériences immersives: jeu de rôle, onboarding, formation

Pour l’éducation et la formation, des scénarios adaptatifs dopés à LaMDA font gagner du temps. Un simulateur de vente B2B qui joue le client difficile, un coach produit qui challenge l’argumentaire, un quiz dynamique qui détecte les lacunes : tu entraînes tes équipes sans monopoliser les seniors.

- 🎮 Role-play : objection handling, négociation, découverte des besoins.

- 📚 Knowledge : base interne et notes de REX connectées en RAG.

- 🧭 Guidage : feedback instantané, scoring, suggestions d’amélioration.

- ⏱️ ROI : temps de montée en compétences réduit de 30–50 % selon complexité.

Besoin d’un cadrage rapide ? Ce tableau résume où LaMDA frappe fort et comment mesurer le succès.

| Cas d’usage 🎯 | Indicateur clé 📊 | Stack recommandée 🧰 | Garde-fous 🛡️ |

|---|---|---|---|

| Support L1 📞 | Auto-résolution ≥ 60 %; CSAT ↑ | Dialogflow + LaMDA + CRM | Filtres + handover humain |

| Recherche vocale 🔊 | Latence < 1,2s; exactitude ↑ | Assistant Google + API stock | RAG + réponses sourcées |

| Onboarding 🚀 | Time-to-proficiency ↓ | LaMDA + LMS | Journalisation + audits |

| Qualification commerciale 💼 | Taux de RDV ↑ | LaMDA + CRM + Calendar | Consentements + opt-out |

Tu vois l’idée : une conversation naturelle, des données fiables, des métriques serrées. Ensuite, on passe à la méthode d’implémentation.

Implémenter LaMDA avec Dialogflow: méthode pas à pas, prompts robustes et intégration données

Le bon setup évite 80 % des frictions. Ici, l’objectif est simple : une architecture claire, des prompts stables, un flux de données propre. Tu n’as pas besoin d’une armée d’ingénieurs, tu as besoin de rigueur.

Étapes clés de l’implémentation

- 🧭 Cartographie des intentions: 10–20 intents couvrant 80 % des cas. Regroupe, débruite, supprime le superflu.

- 🧱 Orchestration avec Dialogflow CX: états, transitions, webhooks. LaMDA gère les réponses longues; Dialogflow gère le flow.

- 📚 RAG minimal viable: indexe FAQ, politiques, fiches produits. Réponses sourcées, liens cliquables.

- 📝 Prompt système signé: ton, contraintes, refus, style (“réponse courte si vocal”, “cite la source si incertain”).

- 🔌 Connecteurs: CRM, inventaire, paiements. Tout ce qui transforme une réponse en action.

- 🧪 Playbooks de test: 50 scénarios réels, 20 frustrants, 10 adversariaux. Évalue en vrai, pas en démo.

- 📈 Observabilité: logs prompts/réponses, traçabilité, dashboards (latence, exactitude, escalades).

Modèle de prompt qui tient la route

Un prompt n’est pas un poème. C’est une spécification comportementale. Pose les règles, les exceptions et la hiérarchie des priorités. Exemple d’ossature à adapter à ton domaine :

- 🧑💼 Rôle : “Tu es l’assistant service client d’un e-commerce.”

- 🔒 Contraintes : “Ne promets pas ce qui n’est pas dans la politique.”

- 🧷 Style : “Clair, concis, ton pro, pas de jargon inutile.”

- 🔗 Sources : “Réponds en citant la source RAG si disponible.”

- 🚫 Refus : “Si question hors périmètre, propose un handover humain.”

Métriques qui évitent l’auto-intox

Sans métriques robustes, tu pilotes à vue. Un set minimal te donne la vérité terrain :

- ⏱️ Latence p95 (objectif < 1,5s en vocal).

- 📦 Taux d’auto-résolution par intention.

- 🧪 Exactitude via évaluations humaines hebdo sur un échantillon stable.

- 🧯 Hallucinations détectées/évitées via test adversarial.

- 📣 CSAT/NPS post-échange, contextualisé par type de demande.

Tu veux voir une mise en place similaire en action ? L’écosystème regorge de démos utiles pour structurer ton chantier.

Pour suivre les signaux du marché et les retours d’équipes produit, reste en veille active sur les annonces de Google et de l’écosystème.

En suivant ce plan, tu installes des fondations solides. Passons au choix stratégique des modèles selon tes contraintes.

LaMDA vs OpenAI, DeepMind et l’écosystème: quel modèle pour quel besoin (coût, latence, conformité)

Pas de guerre de chapelles. Tu dois arbitrer entre LaMDA, les offres OpenAI et les modèles issus de DeepMind et d’autres acteurs, selon trois critères : coût/latence, qualité sur ton domaine, conformité. La meilleure décision est rarement “un seul modèle partout”.

Quand privilégier LaMDA

- 💬 Dialogues ouverts multi-intentions où la continuité du contexte est critique (SAV, accompagnement onboarding).

- 🔊 Interfaces vocales où un style naturel, concis et tolérant aux reformulations est décisif.

- 🌐 Intégration Google-native (Assistant, Search, cloud, Dialogflow) avec bénéfices d’orchestration et de monitoring intégrés.

Quand regarder OpenAI

- 🧩 Raisonnement multi-étapes sur documents hétérogènes et tâches analytiques lourdes, avec outils externes.

- 🛠️ Écosystème outillé (plugins, agents, code-exec) et communauté très active pour prototyper vite.

- 💸 Arbitrage coût si les tokens et latences conviennent à tes flux (à estimer sur tes charges réelles).

Et l’apport DeepMind

- 🧠 Recherche fondamentale et innovations sur l’alignement, la robustesse et l’évaluation systémique.

- 🏗️ Modèles multimodaux applicables à vision + texte + actions, selon tes cas d’usage.

- 🧪 Benchmarks utiles pour juger la robustesse hors démo marketing.

Cas pratique. Une marketplace B2C avec gros volume de questions simples + pics saisonniers. Choix : LaMDA pour front vocal/chat L1 avec Dialogflow, un modèle OpenAI pour l’analyse de verbatims et la priorisation de tickets, un moteur interne pour la recommandation. Résultat : coûts maîtrisés, expérience stable, reporting propre. Tu te concentres sur la valeur, pas sur la techno fétiche.

Tu veux un plan anti-surprise ? Établis une matrice de décision par cas d’usage : exactitude attendue, tolérance à l’erreur, SLA, budget par 1 000 interactions, contraintes juridiques. Ensuite, exécute des POCs de 2 à 4 semaines avec jeux de données identiques. Décide sur chiffres, pas sur intuition.

- 📏 Évalue sur ton corpus, pas sur des benchmarks génériques.

- ⛓️ RAG d’abord pour fiabilité, puis raisonnement avancé si nécessaire.

- 🧮 Coûts complets = tokens + observabilité + réétiquetage + gouvernance.

- 🗂️ Plan B de bascule modèle si dérive qualité/coût.

L’arbitrage gagnant reste le même : un modèle pour la conversation naturelle (LaMDA), un pour l’analyse et la classification (OpenAI ou autre), une couche de données robuste. Tu construis un système, pas un totem.

Gouvernance, sécurité et SEO: exploite LaMDA sans risque ni bruit inutile

Si tu mets LaMDA en prod sans garde-fous, tu joues à pile ou face avec ta marque. La maturité, c’est la combinaison de politiques claires, d’outils de contrôle et d’une boucle qualité continue.

Garde-fous indispensables

- 🚧 Filtres de contenu avant et après génération (P0) avec règles durcies sur les domaines sensibles.

- 🔐 Sécurité : chiffrement en transit/au repos, signatures de prompts, rotation des clés, cloisonnement des logs.

- 🧯 Handover humain sur signaux de confusion, colère ou transaction à risque.

- 🧿 Red teaming trimestriel avec scénarios adversariaux documentés.

- 📚 RAG avec citations et liens : la meilleure réponse est celle que l’on peut vérifier.

Conformité et traçabilité

Traite la confidentialité comme un KPI. Journalise les décisions, pseudonymise les données, gère les consentements. En cas d’audit, tu dois remonter qui a demandé quoi, pourquoi la réponse a été donnée, et sur quelles sources elle s’appuyait.

- 🗃️ Data lineage de bout en bout (requête → contexte → réponse → action).

- 🧾 Politiques d’accès minimales et revues mensuellement.

- 🧩 Évaluations humaines régulières sur un échantillon stable, annoté et versionné.

- 🗑️ Retention limitée et purges programmées.

SEO conversationnel: transformer le dialogue en trafic qualifié

La bascule vers le SEO conversationnel est amorcée. Les assistants et la Recherche vocale privilégient des réponses courtes, exactes, avec preuves. Si tu veux capter ce trafic, structure tes contenus et tes données pour qu’un agent boosté à LaMDA puisse répondre sans hésiter.

- 🧭 Pages “réponses courtes” par intention, données structurées, FAQ intégrées.

- 🔗 Sources citables (docs, guides, fiches) avec liens profonds et mises à jour versionnées.

- 🗣️ Micro-réponses vocales (30–60 mots), ton didactique, appel à l’action net.

- 📊 Tracking des impressions vocales et des conversions post-réponse.

Un éditeur média a structuré 200 réponses courtes autour de ses requêtes cœur. En 90 jours, +24 % de captures via assistants, -18 % d’abandons sur les parcours d’info rapide. Le contenu n’a pas “gonflé” : il a été restructuré pour servir des agents conversationnels.

Tu as le plan. Reste à l’exécuter sans raccourcis. Voilà. Tu sais quoi faire. Le reste, c’est toi contre ton inaction.

LaMDA est-il adapté aux PME sans équipe data dédiée ?

Oui, si tu limites l’ambition au départ. Cible 10–20 intentions récurrentes, branche Dialogflow pour l’orchestration, ajoute un RAG léger (FAQ, politiques). Mesure latence, auto-résolution et CSAT chaque semaine. Tu montes en puissance par itérations courtes.

Quelle différence entre LaMDA et les modèles d’OpenAI pour un chatbot SAV ?

LaMDA excelle en dialogue naturel et en continuité de contexte, utile en SAV multi-rebonds. OpenAI peut être choisi pour l’analyse documentaire et des tâches de classification/raisonnement plus lourdes. En pratique, beaucoup d’équipes combinent les deux selon le besoin.

Comment éviter les hallucinations en production ?

Mise en place d’un RAG avec sources vérifiables, prompts qui imposent “je ne sais pas” en cas d’incertitude, échantillons adversariaux réguliers, et journalisation des réponses à risque. Un handover humain est déclenché sur signaux faibles (langage spéculatif, manque de source).

LaMDA peut-il améliorer la Recherche vocale localisée ?

Oui, si tu exposes stock, horaires, politiques locales et promotions via API. Style concis, confirmation d’intention, et latence p95 < 1,2s. Résultat : plus d’appels utiles, moins de rebonds, plus de visites en point de vente.

Quel est le rôle de DeepMind dans tout ça ?

DeepMind pousse la frontière de la recherche et de l’alignement. Même si les produits diffèrent, les avancées irriguent l’écosystème Google et renforcent les méthodes d’évaluation, la robustesse et la sécurité des agents conversationnels.

Moi c’est Mariane (avec un seul “n”).

J’ai troqué les process corporate contre des contenus qui claquent (et qui rankent).

Passionnée par le business en ligne, le SEO et l’IA, je transforme les idées floues en stratégies digitales qui font du bruit là où ça compte : dans les résultats. Je crois qu’avec un peu de tech, beaucoup d’audace, et une bonne dose de clarté, on peut faire exploser bien plus que des KPI.